Wichtige SEO-Basics, die du regelmäßig überprüfen solltest

In Zeiten, in denen ein Google-Update dem nächsten folgt und eigentlich niemand mehr so wirklich sicher sein kann, dass seine Website ohne großes Zutun auch zukünftig gut in der Suchmaschine zu finden sein wird, ist eines wichtiger denn je: Das Grundkonstrukt einer Website muss stimmen.

In der täglichen Arbeit mit Kunden fällt eines auf: Viele sind auf der Suche nach dem heiligen Gral und nach dem „nächsten großen Ding“. In der Hoffnung, dass es eine Abkürzung zur Verbesserung der Suchmaschinenpositionen geben könnte, werden zumeist unüberlegt zahlreiche Baustellen aufgemacht, wobei keine so richtig intensiv und nachhaltig vorangetrieben wird. Dass die SEO-Basics dabei außen vor gelassen werden, ist leider absolut keine Seltenheit. Weshalb also nicht erst einmal das Grundkonstrukt einer Website auf den neuesten (SEO-)Stand bringen, bevor weitere Maßnahmen ergriffen werden?

Dieser Artikel soll ein Anstoß sein, die eigene Website auf Herz und Nieren hinsichtlich wichtiger SEO-Basics zu prüfen, bevor andere ressourcenintensive Online-Marketing-Maßnahmen eingeläutet werden. Generell ist es ratsam, die Vitaldaten und Performance seiner Website regelmäßig zu prüfen, damit eventuelle Fehlerquellen nicht unbemerkt bleiben und später wohl oder übel von Google „bestraft“ werden.

Duplicate Content

Duplicate Content ist ein leidiges Thema, mit dem unter anderem Online-Shop-Betreiber besonders zu kämpfen haben. Duplicate Content kann selbst verursacht werden, zum Beispiel in dem derselbe Inhalt über unterschiedliche URLs derselben Website oder über verschiedene Domains hinweg abgerufen werden kann. Duplicate Content kann aber auch durch Dritte entstehen, zum Beispiel, wenn die Inhalte einer Website kopiert werden.

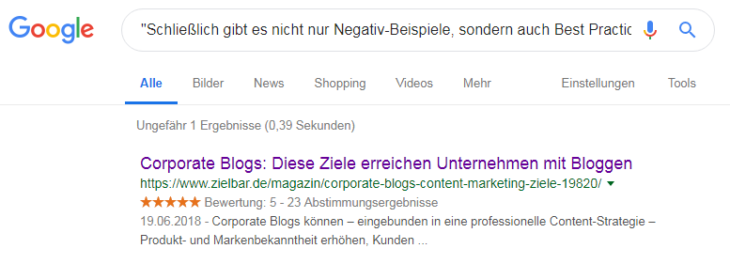

Dass sich Duplicate Content direkt negativ auf ein Projekt auswirkt, darf man bezweifeln. Die jeweilige Bewertung hängt von den individuellen Gegebenheiten der betreffenden Website(s) ab. Grundsätzlich ist es jedoch ratsam, die doppelten Inhalte soweit wie möglich einzudämmen. Duplicate Content kann relativ einfach über die klassische Google-Suche aufgespürt werden. Dazu wird ein Textschnipsel in Anführungszeichen in die Suchmaske eingegeben. Daraufhin zeigt die Suchmaschine alle Seiten an, die diesen Textschnipsel ebenfalls beinhalten. Um tatsächliche Duplicate-Content-Treffer zu bekommen, empfiehlt es sich, einen etwas längeren Textschnipsel zu verwenden (maximal 32 Begriffe):

Über die klassische Google-Suche kann Duplicate Content relativ leicht identifiziert werden.

URL-Struktur

Die URL-Struktur solltest du regelmäßig prüfen. Das gilt vor allem für Shop-Betreiber, da sich durch neue Features oder Updates stetig neue Herausforderungen ergeben können. Grundsätzlich sollte eine Website über sprechende URLs verfügen. Das bedeutet im Prinzip nichts anderes, als dass der Nutzer allein beim Anblick der URL sehen kann, worum es auf der jeweiligen Seite geht.

Eine sprechende URL ist beispielsweise: https://www.zalando.de/herrenschuhe/

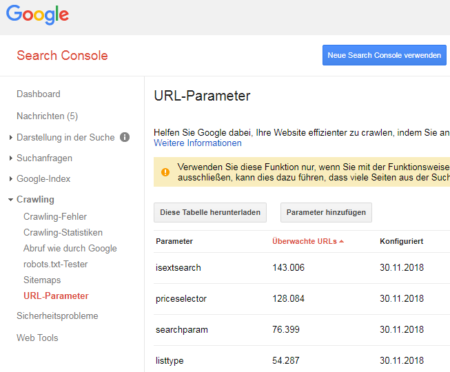

Neben dem Faktor, dass die URL eine möglichst hohe Aussagekraft haben sollte, ist es auch wichtig, die URL-Parameter im Blick zu behalten. Denn durch neue Funktionen wie Filter oder Produktsuchen können URL-Parameter entstehen, die zuvor eventuell noch gar nicht gegeben waren. URL-Parameter sollten hinsichtlich des Crawlings und der Indexierung geprüft werden. Handelt es sich beispielsweise um für die Google-Suche irrelevante Parameter, so kann dies unnötigerweise das Crawl-Budget belasten (betrifft primär große Shops) oder sogar zu Duplicate-Content-Problematiken führen.

Die Google Search Console bietet eine gute Übersicht sowie eine Konfigurationsmöglichkeit für alle identifizierten URL-Parameter.

Etwaige URL-Parameter können über die Google Search Console identifiziert und konfiguriert werden.

Meta-Daten

Man glaubt es eigentlich kaum, wenn man täglich mit SEO zu tun hat, aber die korrekt ausgefüllten Meta-Daten beinhalten tatsächlich auch heute noch ein großes Potenzial. Denn: Viele Websites verfügen zwar grundsätzlich über Meta-Daten wie Page-Title und Meta-Description, doch sind sie in aller Regel nur unzureichend oder überhaupt nicht auf die Suchintentionen der Nutzer und deren Bedürfnisse ausgerichtet. In Verbindung mit einer klassischen Keyword-Recherche sollten die Page-Title und auch die Meta-Descriptions ganzheitlich angepasst werden.

Für große Online-Shops empfiehlt es sich, Schablonen zu entwerfen, die beispielsweise rubrik- oder produktübergreifend genutzt werden können. In den meisten Fällen ist dieses Vorgehen vor allem für die Erstellung der Meta-Descriptions interessant. Um die Page-Titles und Meta-Descriptions aller Unterseiten einer Website abrufen zu können, empfiehlt sich ein Tool wie der Screaming Frog SEO Spider. In der Search Console können unter dem Punkt „HTML-Verbesserungen“ zudem weitere wichtige Daten abgerufen werden. Unter anderem: doppelte Metabeschreibungen, fehlende Title-Tags und vieles mehr.

XML-Sitemap

Die XML-Sitemap ist nicht für die Indexierung wichtig – die geschieht auch ganz ohne deren Hilfe. Vielmehr ist die Sitemap als eine Art Index zu verstehen, den die Suchmaschinen-Bots während des Crawlings abarbeiten können. Es geht also darum, das Crawling der Bots gewissermaßen steuern zu können. Oft ist es so, dass irgendwann einmal eine XML-Sitemap angelegt und seitdem nie wieder überprüft wurde.

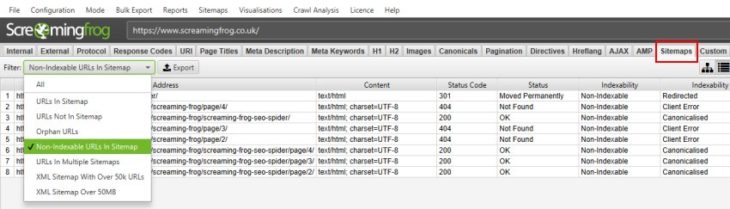

So kann es vorkommen, dass dort plötzlich irrelevante URLs, kanonisierte URLs oder nicht für den Suchmaschinenindex vorgesehene URLs auftauchen. Im Idealfall beinhaltet die XML-Sitemap hingegen ausschließlich diejenigen Unterseiten, die einen Mehrwert bieten, für Nutzer interessant sind und mit denen Rankings in den Suchmaschinen erzielt werden sollen. Dies sollte regelmäßig geprüft werden, damit die Bots nicht irregeleitet werden und das Crawl-Budget nicht unnötig belastet wird.

Die Google Search Console gibt übrigens nützliche Hinweise, wenn es zu Problemen kommt, die von der XML-Sitemap ausgehen. Aber auch mittels Screaming Frog kannst du die die XML-Sitemap effektiv prüfen. Der Screaming Frog gibt beispielsweise Aufschluss darüber, ob es sich bei den Einträgen in der Sitemap um kanonisierte URLs, URLs mit No-Index-Tag oder um Duplikate handelt.

Der Screaming Frog bietet eine Vielzahl an Möglichkeiten, um XML-Sitemaps auf ihre Validität zu prüfen

Backlinks

Die Backlinks spielen noch immer eine elementare Rolle, was die Auffindbarkeit einer Website in den Suchmaschinen angeht. Grund genug, die eigene Backlinkstruktur regelmäßig einer Prüfung zu unterziehen.

Bei dem Check geht es vor allem um folgende Punkte:

- Gibt es eine extreme Zunahme von Spam-Backlinks? Besteht Handlungsbedarf?

- Falls ja: Links für ungültig erklären

- Falls nein: Entwicklung weiter beobachten

- Sind Links entfernt worden?

- Falls ja: Webmaster identifizieren und um erneute Linksetzung bitten.

- Existieren Broken Links?

- Falls ja: Webmaster identifizieren und um Anpassung des Linkzieles bitten oder eine 301-Umleitung für das aktuelle Linkziel auf eine relevante Unterseite einrichten.

Des Weiteren sollte immer Ausschau nach neuen Link-Potenzialen gehalten werden. Dazu sind konkurrierende und themenrelevante Websites eine gute Anlaufstelle. Oftmals treten Potenziale ans Licht, die man in der täglichen Arbeit gar nicht (mehr) auf dem Radar hatte. Hilfreiche Tools zur Analyse der Backlinks sind unter anderem: Majestic, Ahrefs und LinkResearchTools.

Selbstverständlich gibt es noch viele weitere SEO-Basics, die nicht außer Acht lassen solltest. Worauf achtet ihr besonders beim routinemäßigen Check eurer Websites? Schreibt mir gerne euer Feedback in die Kommentare.

Artikelbild: Martin Mummel/GRVTY

Guter Artikel. Guter Hinweis mit den Meta-Daten. Das muss ich selbst noch einmal auf meiner Webseite überprüfen. Danke.

Danke für die Blumen! :)