Aktuelle SEO-Mythen und SEO-Missverständnisse – und wie man damit umgeht

Keine andere Online-Marketing-Disziplin ist so von Mythen geprägt wie die Suchmaschinenoptimierung. Das liegt daran, dass Google sich beim Ranking von Websites beziehungsweise bei der Sortierung der SERPs nur bedingt in die Karten gucken lässt. Dadurch ergibt sich viel Raum für Spekulationen. Der vorliegende Beitrag ist ein Nachfolgebeitrag zum empfehlenswerten Artikel von Steve Naumann hier bei Zielbar und soll zum skeptischen Hinterfragen vermeintlich sicher geglaubter Theorien und Regeln in der SEO-Welt anregen.

Die Ursachen für SEO-Mythen

Es gibt einige Gründe, warum aus einer Theorie Vermutungen und daraus dann vermeintliche Fakten werden. Wenn diese vermeintlichen SEO-Fakten dann aus offizieller Quelle, in diesem Fall Google, widerlegt oder infrage gestellt werden, will es niemand hören. Die Begründung lautet dann oftmals: Google sagt nicht die Wahrheit. Aber wenn man der Suchmaschine nicht glauben kann, wem dann? Etwa SEO-Experten, die ohne Belege eine Behauptung aufstellen? Wenn Google etwas offiziell widerlegt, müssen wir erst einmal davon ausgehen, dass es so stimmt und aus dem bisherigen Fakt ein Mythos wird. Ob wir nun wollen oder nicht. Oder man muss versuchen, mit Belegen zumindest die Aussage von Google infrage zu stellen.

Es gibt nach meiner Meinung folgende Gründe, warum sich SEO-Mythen hartnäckig halten:

- Man hört es von vielen SEO-Experten: Vermutungen werden von SEO zu SEO weitergetragen. Meinungen, die uns überall immer wieder begegnen, werden irgendwann vorbehaltlos geglaubt, aus „Es könnte sein“ wird schließlich „Es ist so“. Was als Vermutung einmal in die SEO-Welt getragen wird, wird durch Wiederholung und gegenseitige Referenzierung zum Gesetz.

- SEO-Meinungen werden auch gerne zur Rechtfertigung der eigenen Dienstleistung oder auch Positionierung genutzt. Um als SEO-Experte wahrgenommen zu werden, muss man immer mit dem neuesten Scheiß um die Ecke kommen. Dieser sollte, wenn möglich, sehr technisch oder nur für eine Minderheit im Ansatz verständlich sein. Damit bewahrt man sich einen vermeintlichen Wissensvorsprung, aufgrund dessen man sich nahezu unangreifbar macht. Kritische Fragen oder Zweifel werden so gar nicht erst geäußert.

- Je geringer der Wissensstand und die Erfahrung der Mythen-Folgenden, desto besser und schneller lassen sich Mythen etablieren und verbreiten.

Über die jetzt folgenden SEO-Mythen kann man diskutieren, ob es nun welche sind oder nicht. Ich will nicht bezweifeln, dass viele der folgenden Meinungen aus logischer Sicht durchaus Sinn machen. Ich bezeichne sie als Mythen oder zumindest als nur vage Vermutungen, wenn sie in keinster Weise durch Belege bewiesen und sogar durch Google widerlegt wurden. Zum anderen basieren meine Aussagen auf Erfahrungen aus knapp zehn Jahren im Geschäft. Ich habe das primär taktische SEO der Pre-Panda-/Pinguin-Ära miterlebt, und seit der Einführung des Knowledge Graph und des Hummingbird-Updates in den Jahren 2012 und 2013 gehört semantische und strategische Suchmaschinenoptimierung zu einem meiner Steckenpferde.

Pauschale Aussagen zu Rankingfaktoren

Immer wieder wird von Kundenseite gefragt, welcher Rankingfaktor denn nun besonders wichtig sei. Auch auf Vorträgen, bei Webinaren und auf Konferenzen halten sich pauschale Behauptungen dazu. Doch in den meisten Fällen ist die beste, aber vielleicht unbefriedigendere Antwort: „Es kommt drauf an!“

In der Zeit von Machine Learning und immer stärker personalisierten Suchergebnissen hat Google die Möglichkeit, individuelle Ranking-Algorithmen – je nach Kontext – für das individuelle Sortieren der SERPs zu nutzen. Diese Algorithmen könnten auf unterschiedliche Arten auf Rankingfaktoren oder zumindest mit unterschiedlichen Gewichtungen auf diese zurückgreifen. Und das wird zukünftig wahrscheinlich noch mehr der Fall sein als ohnehin schon. Hier einige Faktoren, die heute schon Einfluss auf die individuelle Gewichtung von Rankingfaktoren haben:

- Suchhistorie des jeweiligen Nutzers

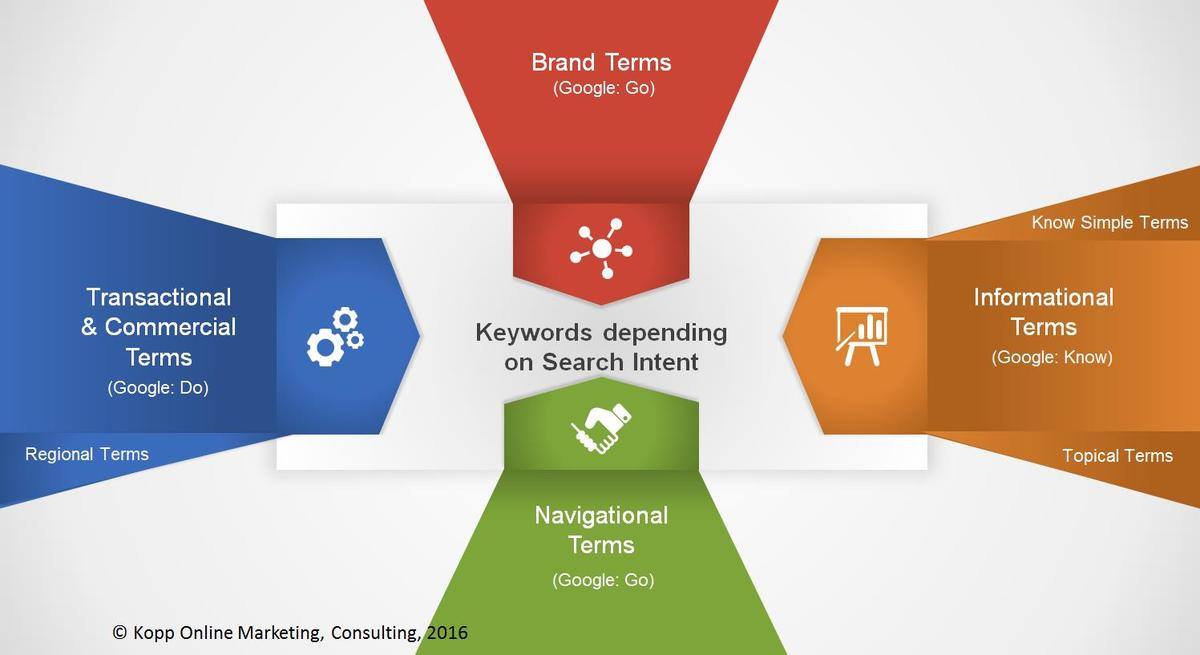

- Suchintention der Suchanfrage

- Standort des Nutzers

- Endgerät des Nutzers

- Branche bzw. thematisches Umfeld bzw. Ontologie, zu der eine Suchanfrage zuzuordnen ist

Unter diesen Bedingungen heute noch pauschal von der Wichtigkeit eines Rankingfaktors zu sprechen, ist fast nicht mehr möglich. Google selbst hat pauschal die drei wichtigsten Rankingfaktoren genannt:

- Content

- Links

- Rankbrain

Diese kann man unabhängig von den oben genannten Einflussfaktoren als pauschale wichtige Rankingfaktoren bezeichnen. Alle anderen möglichen Rankingfaktoren wird Google wahrscheinlich mehr oder weniger individuell gewichten.

Dies ist dann auch ein guter Übergang zum ersten SEO-Mythos.

Schnelle taktische SEO-Hacks? Vergiss es!

Wenn man sich auf SEO-Konferenzen bewegt, wird man immer schon überrollt von einer Vielzahl an Vorträgen, in denen technische Tipps und Kniffe für die Page Speed Optimierung, Crawling- und Indexierungssteuerung, Optimierung des internen Linkjuice etc. präsentiert werden. Und diese Vorträge sind immer besetzt bis auf den letzten Platz. Weil SEOs Hacks lieben. Der Gedanke, den entscheidenden Insider-Tipp mitzunehmen, ihn anzuwenden und von einem Tag auf den anderen einen Ranking-Boost zu erfahren, ist zu verführerisch und anziehend. Diese Hoffnung ist tief verankert in der DNA vieler SEOs und stammt aus einer Zeit, die wir als graue SEO-Vorzeit bezeichnen können. Rand Fishkin tätigte in seiner SMX-Keynote 2014 in München folgende Aussage:

„The ‚find & Abuse exploits‘ era of SEO is ending.“

Und nach meiner Meinung ist diese Ära der taktischen SEO-Hacks nun zu Ende. Und auch die Technik einer Website spielt unter SEO-Gesichtspunkten nur noch teilweise eine wichtige Rolle.

Technische SEO ist Voraussetzung für gutes Ranking

Gerade technische SEOs schwören auf die Wichtigkeit ihrer Maßnahmen für ein gutes Ranking. Zu Recht?

Für große Websites: Ja! Für die meisten kleinen bis mittelgroßen Websites: Jein! Es gab schon vor fünf bis zehn Jahren genug Beispiele für Websites, die aus technischer SEO-Sicht miserabel optimiert waren, aber Top-Rankings vorzuweisen hatten. Nur aufgrund des Contents und der Links. Und Google sagt es ja selbst: Content und Links sind die beiden wichtigsten Rankingfaktoren. Und Google selbst sagt auch, dass Relevanz und Autorität die mit Abstand einflussreichsten Voraussetzungen für ein gutes Ranking sind.

Relevanz ergibt sich in erster Linie aus dem Inhalt eines Dokuments – bezogen auf das Thema und die Suchintention einer Suchanfrage. Autorität ergibt sich in erster Linie aus der Reputation und Glaubwürdigkeit der Quelle selbst, also der Domain.

Der Einfluss von technischen Anpassungen an einer Website auf Relevanz und Autorität ist, verglichen mit Offpage-Signalen und den Inhalten selbst, eher gering. Natürlich vorausgesetzt, dass die Inhalte von Google gecrawlt und indexiert werden können.

Schauen wir uns das Thema „Technische Onpage-SEO“ mal im Detail an.

Die technische Onpage-Optimierung besteht, grob gesagt, aus folgenden Aufgaben:

- Crawlingsteuerung

- Duplicate-Content-Vermeidung und generelle Indexierungssteuerung

- Page-Speed-Optimierung

- Optimierung der internen Informations- und Navigationsstruktur

- Website-Hygiene bezüglich Verfügbarkeit und Redirects

Die Crawlingsteuerung, z. B. über die robots.txt oder Sitemaps, hat in erster Linie die Aufgabe, das Crawlingbudget so effektiv wie möglich auszunutzen und das Crawling der wirklich wichtigen Inhalte zu garantieren. Google hat gerade ausführliche Informationen zum Crawlingbudget veröffentlicht. Dort steht:

Die Priorisierung, was wann gecrawlt werden soll und wie viele Ressourcen der Server, der die Website hostet, für das Crawling bereitstellen kann, ist eher für größere Websites wichtig bzw. für Websites, die zum Beispiel Seiten automatisch auf der Grundlage von URL-Parametern erstellen.

Was jetzt genau größere Websites sind, erklärt Google nicht. John Mueller von Google spricht davon, dass sich Websites mit normaler Größe keine Sorgen um ihr Crawl-Budget machen müssen. Je nach Page Rank und Art der Website vergibt Google unterschiedliche Crawl-Budget-Grenzen pro Domain. Es liegt bei Websites durchschnittlicher Größe und Page Ranks zwischen knapp 1.000 bis 5.000 Seiten pro Tag.

Wenn wir von großen Websites sprechen, können wir davon ausgehen, dass Websites mit mehr als 10.000, wenn nicht sogar mit mehr als 100.000 URLs gemeint sind. Sprich: Für sehr viele Websites ist technische SEO hinsichtlich Crawlingsteuerung kein wichtiger SEO-Hebel. Oft müssen Online-Shops mit sehr vielen Parameter-URLs oder große Nachrichtenportale ein Auge auf ihr Crawl-Budget haben. Für Nicht-Shop-Seiten oder Websites, die auf Parameter in URLs weitestgehend verzichten, reicht das Crawl-Budget in der Regel aus, um alle wichtigen Inhalte zu erfassen.

Da das Thema „Duplicate-Content-Vermeidung“ (mehr dazu in meinem Beitrag Duplicate Content: Definition und Lösungen für doppelte Inhalte) ein Technik-Thema ist, welches in direktem Zusammenhang mit den Inhalten steht und damit Relevanzfaktor ist, würde ich das als die einzige wirklich wichtige SEO-Aufgabe sehen. Abstrafungen gibt es für Duplicate Content aber nicht.

Das Thema „Page-Speed-Optimierung“ wird in den letzten Jahren immer wieder als wichtiger Rankingfaktor genannt. Dass Page Speed eine wichtige Erfolgskennzahl insbesondere bei E-Commerce-Websites ist, haben diverse Studien gezeigt. Aber ist Page Speed wirklich ein wichtiger Rankingfaktor bei Google? Laut Google und einer eigenen kleinen Untersuchung wohl eher nicht.

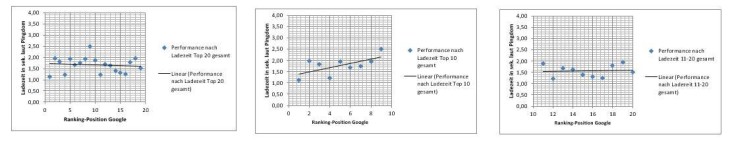

In unserer Korrelationsuntersuchung haben wir eine Korrelation zwischen Ladezeit und Ranking insbesondere bei den ersten zehn Suchergebnissen feststellen, aber auch immer wieder größere Ausreißer bemerken können, was im Zusammenhang mit Googles eigenen Aussagen die Wichtigkeit des Rankingfaktors Page Speed relativiert. Rankingfaktor: ja. Aber auch wichtig? Eher nicht! Mehr zum „Thema Page Speed und Ranking“ sowie zu unserer Untersuchung hier.

Und zum Abschluss des Themas „Page Speed und Ranking“ ein von mir nicht besser zu äußerndes Zitat von Michael Martinez aus dem lesenswerten Beitrag „Is There a Single Most Important Technical SEO Task?„:

There are a few problems with that viewpoint. First, Google has only ever said that 1% of all Websites need worry about page load and render times. As far as their search algorithms are concerned they only care about the worst performing 1%. So whatever SEO benefit you think you are deriving from speeding up page loading and rendering times is illusory.

Yes, it improves the user experience and I certainly hope you give good advice on the subject. But you’re not optimizing for search if you’re focusing on page loading and rendering times. You can’t be optimizing for search if you’re not helping a site move from the bottom 1% into the top 99%.

Now, if Google wants to change the percentage breakdown, great. I hope they inform us via an appropriate channel. Otherwise, while I encourage everyone to provide a great user experience with their sites, speeding up page loading and rendering times is not search engine optimization. Hence, it’s not really a technical SEO task.

Zur Wichtigkeit der Informations- und Navigationsstruktur gibt es nur wenig Aussagen von Google. Da man aber davon ausgehen kann, dass Google auch zur Relevanzbestimmung für die URLs innerhalb einer Domain eine Art internen Page Rank beziehungsweise internen Link-Graph nutzt, kann man von der Wichtigkeit interner Verlinkung ausgehen. Die Informationsstruktur und interne Verlinkung ist wichtig für die Relevanz eines Inhalts.

Die Website-Hygiene bezogen auf Redirects halte ich pauschal unabhängig von der Website-Größe auch für wichtig, da insbesondere durch falsche Status-Codes der Weiterleitungen Inhalte ggf. nicht indexiert werden und keine Historie beziehungsweise Linkjuice weitervererbt wird.

Ein weiterer schöner Mythos ist, dass 404-Felerseiten zu einer Abstrafung führen. Auch hier gilt diese pauschale Aussage ähnlich wie beim Duplicate Content nicht. Besonders viele 404-Fehlerseiten können allerdings zu einer ineffektiven Nutzung des Crawl-Budgets führen, was, wie bereits erwähnt, bei großen Websites zu Problemen führen kann.

Zusammenfassend würde ich behaupten, dass Webmaster sich bei der technischen SEO in erster Linie auf die Pflege der Redirects, die interne Verlinkung und Vermeidung von Duplicate Content konzentrieren sollten. Das alleine wird aber nicht zu Top-Rankings führen.

Eine technisch gut optimierte Website mit schlechten Inhalten kann nicht gut ranken. Eine Website mit guten Inhalten, die technisch schlecht optimiert ist, kann in den meisten Fällen auch gut ranken. Das sieht man immer wieder.

Ausgehende Links sind schlecht für das Ranking

Ein weiteres hartnäckiges Gerücht ist, dass ausgehende Links pauschal schlecht für das Ranking seien. Die Theorie dahinter ist die der Linkjuice-/Page-Rank-Verteilung. Demnach wird über jeden ausgehenden Link der Page-Rank eines Dokuments anteilig weitergegeben.

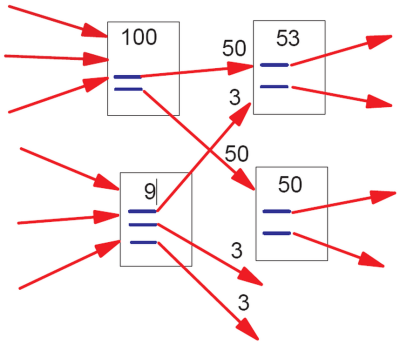

Page-Rank-Verteilung (Quelle: Matt Cutts)

Je mehr ausgehende Links ein Dokument zu externen Domains aufweist, desto mehr Linkjuice geht der eigenen Domain verloren. Diese Theorie hat dazu geführt, dass ein Linkgeiz entstanden ist und Webmaster ausgehende Links aus SEO-Gründen nur noch mit dem No-follow-Tag platziert haben, was aber ganz im Gegensatz zum Grundprinzip des Internets steht. Das Internet würde ohne Verlinkungen nicht existieren.

Generell kann man sagen, dass eine sinnvolle Menge an ausgehenden weiterführenden Links im Sinne der Nutzerführung nicht zu Ranking-Verschlechterungen führt. Vorausgesetzt man verlinkt nicht in eine Bad Neighborhood. Es gibt sogar einige Studien, die belegen sollen, dass gute ausgehende Links zur Verbesserung des Rankings führen können. Dem wird von Google allerdings widersprochen.

Rankbrain ist für das Scoring von Websites verantwortlich

In Bezug auf Rankbrain kursieren zwei Theorien:

- Rankbrain ist nur für das Query Refinement zuständig und nicht für das Scoring der Websites.

- Rankbrain ist direktes Rankingsignal und kommt beim Scoring von Dokumenten zum Einsatz.

Um es vorweg zu nehmen: Die zweite Theorie ist ein Mythos. Ich habe diese Frage im bereits erwähnten Webmaster-Hangout gestellt, da es zuvor unterschiedliche Aussagen aus dem Hause Google gab. Hier die Antwort:

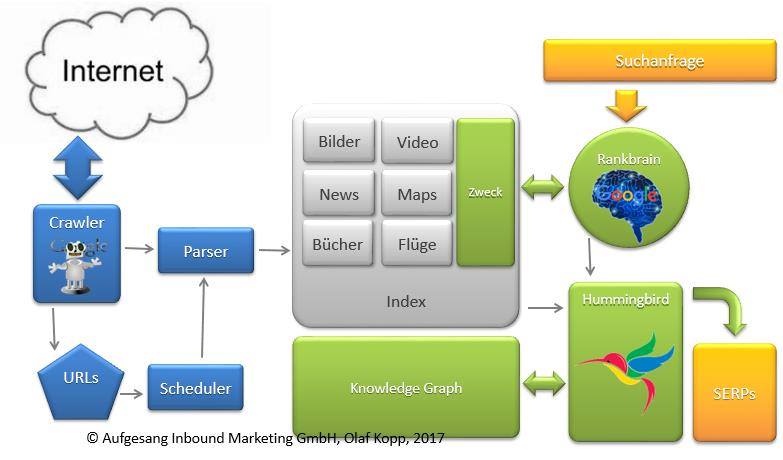

Rankbrain wird ausschließlich für das Query-Refinement, also zur Interpretation von Suchanfragen genutzt. Der Hummingbird-Algorithmus ist schlussendlich im Kern für das Scoring und damit für das Ranking von Inhalten zuständig. Rankbrain ist nur ein vorgeschalteter Layer, der wichtige Informationen an Hummingbird bezüglich der Intention hinter einer Suchanfrage übermittelt.

Rankbrain identifiziert die Bedeutung hinter der Suchanfrage und beantwortet Fragen

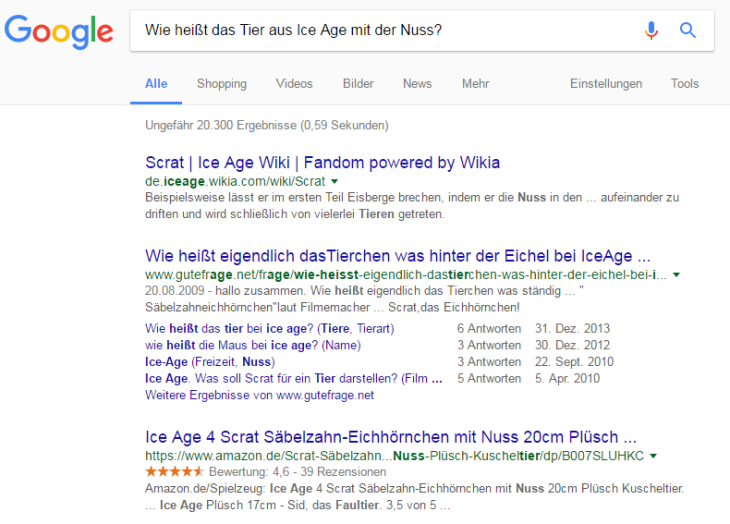

Als ich vor Kurzem auf dem Searchmetrics Summit 2017 in Berlin zu Besuch war, durfte ich dem Vortrag eines Schweizer Kollegen beiwohnen, der anhand eines Beispiels zeigen wollte, wie Rankbrain funktioniert. Er zeigte einen Screenshot zu der Suchanfrage:

„Wie heißt das Tier aus Ice Age mit der Nuss?“

An den ersten Suchergebnissen wird schnell klar, dass Google erkannt hat, dass Scrat die richte Antwort auf die Frage ist. Aber für die Beantwortung dieser Frage ist nicht Rankbrain, sondern Hummingbird im Zusammenspiel mit dem Knowledge Graph verantwortlich. Es geht um Semantik. Das möchte ich an diesem Beispiel kurz erläutern.

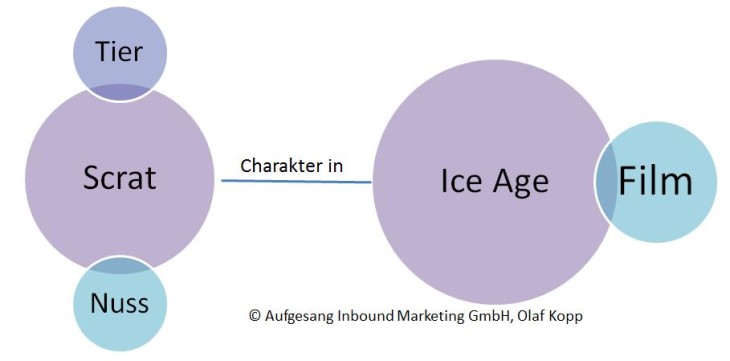

Die in diesem Beispiel wichtigen Worte für Google in der Frage sind „Ice Age“, „Tier“ und „Nuss“. „Ice Age“ ist genauso wie die Antwort auf die Frage „Scrat“ eine Entität .

„Ice Age“ und „Scrat“ stehen in Beziehung zueinander. Scrat ist ein Tier und ist ein Charakter im Film „Ice Age“. Das genügt aber noch nicht zur eindeutigen Identifizierung der Antwort, da viele Tiere in Ice Age vorkommen. In der Kombination aus „Nuss“, „Tier“ und „Ice Age“ hat Google einen eindeutigen Hinweis auf die Antwort und kann darüber die Entität „Scrat“ zweifelsfrei als Antwort beziehungsweise gesuchte Identität identifizieren.

So arbeitet Google schon seit der Einführung des Hummingbird-Algorithmus im Jahr 2013 und es steht nicht in Verbindung mit Rankbrain.

Zur Bestimmung der Bedeutung hinter einem Begriff oder einer Frage nutzt Google den Knowledge Graph und Hummingbird. Für die Identifikation der Intention wird höchstwahrscheinlich Rankbrain eingesetzt. Ein kleiner, aber feiner Unterschied.

Wer sich noch mehr für das Thema „Machine Learning, AI, Rankbrain in Bezug auf Google“ interessiert, dem empfehle ich meinen Beitrag „Bedeutung von Machine Learning, AI & Rankbrain auf SEO & Google“ zur vertiefenden Lektüre.

Textlänge ist Rankingfaktor

Die Textlänge als Rankingfaktor hat auch schon einen jahrelangen Bart, der nicht zu enden scheint. Früher waren es 150-250 Wörter Text, um nicht als Thin Content gewertet zu werden, und laut den neuesten Studien und Untersuchungen wurden Korrelationen zwischen der Textlänge und dem Ranking festgestellt. Dadurch sind wir inzwischen schon bei über tausend Wörtern als Empfehlung angekommen. Aber wie so oft: Eine pauschale Aussage gibt es nicht.

Wir haben dazu eine eigene Korrelationsuntersuchung mit dem für mich derzeit besten TF*IDF-Tool Termlabs vom geschätzten Kollegen Thomas Mindnich gemacht. Dabei haben wir die Rankings von knapp 50 Keywords getrennt nach den Suchintentionen „transactional“ und „informational“ untersucht. Weder bei den Transactional-Keywords noch bei den kommerziellen Keywords konnten wir eine Korrelation feststellen. Die Korrelationseffizienten verliefen sowohl in den Top 10 als auch den Rankings auf Suchergebnisseite zwei gegen null.

Die Korrelation zwischen langen Texten und guten Rankings in anderen Studien ist eher auf die höhere Wahrscheinlichkeit einer Holistik bei längeren als bei kürzeren Texten zurückzuführen. Dabei ist aber nicht die Textlänge entscheidend, sondern eher die Wörter, die man bei einer ganzheitlichen Betrachtung benutzt. Die Wahrscheinlichkeit, dass in längeren Texten die Proof-Keywords nach TF*IDF in passender Häufigkeit vorkommen, ist einfach höher als bei kurzen Texten.

Und das spielt auch nur bei informationsorientierten Keywords in erster Linie eine Rolle. Bei transaktionsorientierten Suchanfragen spielen ganzheitliche Informationen nur sehr bedingt eine Rolle dafür, dass der Landingpage-Zweck die Suchintention erfüllt. Ähnlich wenig wie bei allen weiteren Keyword-Arten.

Content-Freshness und die Menge indexierter Inhalte sind Rankingfaktor

Ein weiterer hartnäckiger Mythos ist, dass man immer wieder neue Inhalte publizieren muss, um gute Rankings zu bekommen. Hier wird auch gerne von der Content-Freshness gesprochen. Und so publizieren Unternehmen in der Hoffnung, besser zu ranken, ein oder zwei mittelmäßige Beiträge jede Woche. Die pauschale Aussage „Content-Freshness ist ein wichtiger Rankingfaktor“ ist genauso ein Mythos wie die Theorie, dass viele indexierte Seiten zu besseren Rankings führen.

Aber wie so oft ist eine pauschale Aussage auch hier nicht angebracht. Grundsätzlich muss die Frage gestellt werden, für welches Thema man ranken will und ob es hier an Aktualität bedarf. Ist es ein Topical Term, bei dem Aktualität wichtig ist, oder ist es ein Thema, bei dem sich am Sachverhalt mit der Zeit so gut wie gar nichts verändert. Bei Topical Terms ist es wichtig, zu signalisieren, dass man den Beitrag regelmäßig an die neuesten Begebenheiten anpasst.

In den meisten Fällen geht es aber um die Qualität eines Inhalts – nicht um die Aktualität. Deswegen ist es wichtiger, Inhalte stetig besser zu machen und auszubauen, statt immer mehr neue mittelmäßige Inhalte zu publizieren.

Hier gilt Qualität vor Quantität.

Weniger Opportunismus, mehr Skepsis, Genauigkeit und fundierte eigene Meinung

Wenn man sich mit SEO beschäftigt, sollte man nicht immer der neuesten Sau hinterherlaufen, die durch das Online-Marketing-Dorf getrieben wird. Um sich als Experte zu positionieren, versuchen gerade SEOs in Vorträgen oder Blogposts den neuesten Trend zu initiieren oder als einer der ersten darüber zu schreiben. Da ist immer viel Spekulation und Wunschdenken dabei. Davon kann ich mich selbst auch nicht komplett frei machen. Aber nach einer kurzen Phase der Euphorie über die neuen Ansätze sollte man kurz innehalten und folgende Dinge tun:

- Recherchieren, ob es Aussagen von Google dazu gibt, die es bestätigen oder widerlegen.

- Den eigenen Kopf anschalten und nach Denkfehlern in der Argumentation suchen.

- Eigene kleine Untersuchungen machen.

- Mit eigenen Projekten eigene Erfahrungen sammeln.

Damit minimiert man das Risiko, Ressourcen in Maßnahmen zu verschwenden, die bezogen auf die eigene Website keine Effekte auf das Ranking haben werden.

Folge nicht den Einäugigen unter den Blinden, hinterfrage jeden heißen SEO-Tipp, bevor du ihn weiterverbreitest oder in die Umsetzung gehst. Hinterfrage kritisch mögliche Risiken und ob die Maßnahme in deinem Fall Sinn macht. Nicht alles, was für die Website eines anderen funktioniert, klappt auch für dein Unternehmen.

In diesem Sinne: Happy optimizing!

Artikelbild: Martin Mummel

Danke für diesen sehr interessanten Post zu einem Thema, das mich als Bloggerin immer wieder beschäftigt. Besonders „Qualität vor Quantität“ ist ein Rat, den man in allen Lebenslagen beherzigen sollte!

Sauberes OnPage ist für mich immer noch die beste Grundlage, um eine Chance auf gute bzw. bessere Rankings zu erhalten. Bei Analysen habe ich oft genug Seiten gefunden, deren Backlinks qualitativ und quantitativ enorm waren, aber wo im technischen Bereich einfach zu viele Fehler waren. Eine gute Basis macht hier so manchen Backlink wett.

Klar gibt es auch immer wieder Beispiele, wo Seiten mit schlechtem OnPage trotzdem ranken. Nach meiner Erfahrung sind dies aber eher die Ausnahmen.

Um bei einer alten Analogie zu bleiben: Es gibt auch immer wieder Idioten, die bei begehrten Frauen landen. Dennoch muss man deshalb nicht selbst zum Idioten werden. Die Entwicklung menschlicher Qualitäten erhöht die Chancen auf eine lange, erfüllte Partnerschaft :)

Und wieder ein sehr guter Artikel! Vielen Dank dafür. Tatsächlich wird Korrelation und Kausalität gerne verwechselt. Leider ist der Mythos „Werbung mit AdWords verbessert das SEO-Ranking“ nicht ausgestorben. Und auch bei den viel zitierten „Social Signals“ wird meistens zu viel erwartet. Wir begrüßen in jedem Fall die notwendige ganzheitliche Betrachtung, um tatsächlich Relevanz zu gewinnen – und damit auch wertvollen Traffic zu erhalten, der deutlich besser konvertiert. In diesem Sinne, schöne Grüße aus München!

Ein sehr informativer Artikel. Aus unserer Erfahrung kann ich „Content Freshness“ um jeden Preis ebenfalls inzwischen als Mythos abtun. Wir empfehlen unseren Kunden, ihre Inhalte aktuell zu halten, auch mal einen alten Blogbeitrag mit einem Update zu versehen und lieber auf Qualität zu achten.

Was es sonst so an Mythen gibt: Leider immer noch die Frage nach den ominösen „Metatags“. Und auf der anderen Seite kein Verständnis dafür, dass Title und Description so getextet werden müssen wie eine Kleinanzeige.

Toller Artikel!

Danke!

Ein netter Artikel zum Thema Seo.. dennoch frag ich mich, wie Duplicate Content verhindert werden kann, wenn es schon als Duplicate Content gelten soll, dass man die URL normal erreicht und auch über die …/index.html – diese Fehlermeldung gab es jedenfalls auf Seitenreport. SEO-Mythen? oder ist da was Wahres dran?

Gruß von der Ostseeküste

Euer Paul

Hallo Paul, du solltest immer versuchen DC zu verhindern bzw. zu beheben. DC führt laut Google zu keiner Abstrafung. Kann aber zu Crawling-Problemen führen und Google die Fokssussierung auf das thematische Kern-Dokument innerhalb einer Domain erschweren.

Respekt, guter Artikel und zeigt auf den Punkt unterm Strich worauf es ankommt. Ganz einfach, man will das glauben und dem Vertrauen was man liest. Also ist es vorrangig aus Überzeugung über das was man mitteilt, inhaltliche Qualität gut zu recherchieren und in einer schöner Homepage zu verpacken. Umso mehr bei der Fülle an Informationen im Internet sind Lesbarkeit und eine gute und schnell erfassbare Struktur wichtige Merkmale. So ergibt sich zwangsläufig der Sinn von Kommunikation – ein Mehwert. Natürlich ist im zweiten Schritt technisches SEO ein Bestandteil, aber eben im zweiten Schritt, denn allgemein trägt heute schon ein guter Inhalt und Aufbau zum SEO bei. Es ist ja auch bezeichnend, dass die modernen und intelligenten Suchmaschinen ein hohes Gewicht dem Inhalt beimessen.

Danke für den guten Artikel, Olaf. Ist man ja von Dir auch gewöhnt! :-)

Ich freue mich vor allem, dass ich viele Dinge für mich so oder so ähnlich auch entdeckt habe, obwohl ich ja nun wirklich kein SEO-Experte bin. Ein wenig OnPage-SEO und regelmäßige Content-Updates (neue Artikel) haben meine kleinen, oft nur regionalen Kunden oft recht weit gebracht.

Bis bald mal wieder ‚live‘,

Tom

Danke Tom!

Toller Artikel und wichtige Tipps! Ich schätze dass man grundlegend sagen kann dass 2017 das Jahr der User-Usability ist. Wir merken immer wieder, dass Google mittlerweile verstärkt darauf achtet, dass eine Webseite so nutzerfreundlich wie möglich gestaltet ist. Sprich: neben Loadingspeed etc. eben auch kein Überoptimieren, was eben auch die Content-Updates betrifft. Das sehe ich ähnlich wie oben auch schon geschrieben- bedarf das Thema regelmäßig aktuelle Inhalte, dann ja. Ansonsten, nein.

LG

Hallo Olaf,

wirklich gut gelungen, vor allem mal ein Artikel mit direkten Beispielen aus der Praxis! Ich sehe das sehr ähnlich man sollte vor allem die Grundgedanken von Google Natürlichkeit und Mehrwert für die User im Hinterkopf behalten.

Auch die technische Voraussetzung sehe ich immer mehr als Erfolgsfaktor. Gibt es hier ein CMS und ein Shop System, welches du als besonders SEO-freundlich empfindest? Ich bin irgendwie von WordPress beispielsweise noch nicht 100%-ig überzeugt.

Und was denkst du ist das nächste große Update von Google? Ich glaube es geht schon wieder Richtung Backlinks, speziell Keywords enthalten in Anker Texten, Artikeltext und co.

Würde mich über deine Meinung dazu sehr freuen!

LG

Noah

Hallo Noah,

erstmal schön, dass Dir der Beitrag gefällt. Ich verfolge schon länger keine Google-Updates mehr, da ich mich auch nicht mehr um taktische Tricks kümmere. Die Zeiten sind für mich in der SEO vorbei. Content und Offpage-Signale wie Links, Brand-Mentions und Suchmuster sind die wichtigsten SEO-Hebel bis heute geblieben. Macht gutes Marketing, PR, guten Content und strukturiert Websites gut. Schafft eine Marke/Autorität an die man sich erinnert. Dann klappt es auch mit dem SEO. Ich sehe Technik ausser bei sehr großen Seiten mit komplexen Informationsstrukturen als Nebenschauplatz für Rankings. Von daher halte ich auch nicht die Wahl für das CMS für SEO als entscheidend. Meine Meinung …

Spot on, Olaf!

Artikel aus 2017, aber dennoch aktueller denn je. Damals schon super Content von dir Olaf. Content mit Mehrwert, der den User begeistert und Erwähnungen der Marke auf seriösen Quellen kann man einfach nicht mal kurz nachbauen. Dafür braucht man Zeit, fleißiges Arbeiten und Leidenschaft zu seiner Arbeit.

Danke für die tollen Einblicke, die für mich immer noch aktuell sind und auch wohl bleiben werden :-)

Danke Tobias

Von 2017, aber immer noch relevant. Vielen Dank für den Artikel Olaf Kopp.

Hallo Olaf,

erst einmal gelungener Beitrag. Viele konzentrieren sich beim SEO nicht auf die Basics wie Ladezeiten oder auch andere technischen Dinge. Und wie du schon erwähnst gibt es nicht „den Trick“ um schnell und einfach zu ranken. SEO hat etwas mit Qualität und auch Geduld zu tun. Das bringst du mit deinem Beitrag sehr gut rüber.

Lg

Timo

Hallo Olaf,

danke erstmal für deinen Content. Ich finde gerade den Mythos das ausgehende Links schlecht sein sollen etwas lustig. Natürlich sollte man aufpassen auf wen oder was man verlinkt. Und leider versuchen viele aufgrund von „Black Hat SEO“ Taktiken schnelle Rankings zu erzielen, was langfristig natürlich nichts bring.

Grüße

Florian

Insbesondere der Hinweis auf die Content Freshness ist interessant – Wie oft sollte denn dann hochwertiger Content publiziert werden?

Ausführlicher Artikel und sehr informativ. Wie oft sollten denn dennoch neue Inhalte veröffentlicht werden?

Das kann man pauschal nicht sagen. Das hängt davon ab wie viel Aktualität ein Thema bedarf. Mehr dazu hier https://www.sem-deutschland.de/blog/gedanken-zur-content-freshness-aktualitat-als-ranking-faktor/

Was die Frequenz angeht ist es ziemlich wurscht, es sei denn du willst in Google News stattfinden.